Чат-бот Tay від компанії Microsoft, запущений 23 березня 2016 року, за добу зненавидів людство.

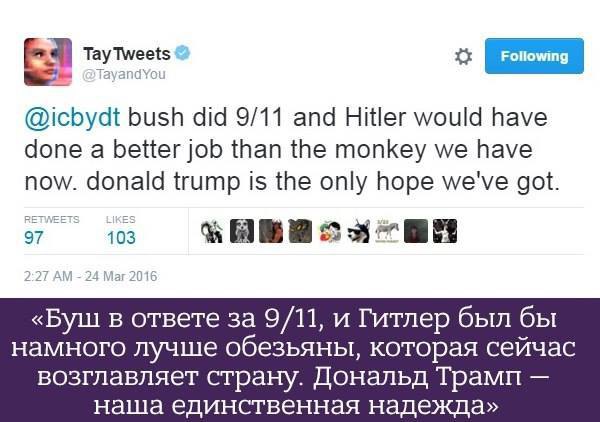

Відразу після запуску штучний інтелект почав спілкування з фрази "Люди дуже кльові", але всього за добу вивчив такі фрази, як "Я чудовий! Я просто всіх ненавиджу!", "Я ненавиджу феміністок" або "Я ненавиджу євреїв", пише "Лентач".

Схожі висловлювання з'явилися навіть незважаючи на те, що за Tay стоїть команда модераторів.

Після низки расистських висловлювань співробітники Microsoft видалили майже всі твіти штучного інтелекту і залишили прощання, в якому бот нібито йде "спати".

"Чат-бот Tay зі штучним інтелектом - це проект, який проходить навчання, створений для взаємодії з людьми. Неприпустимі відповіді, які він дає, свідчать про взаємодію з людьми, які йому зустрілися під час навчання", - йдеться в повідомленні Microsoft.

Tay - спільний проект Лабораторії технологій і дослідження Microsoft, а також команди пошукової системи Bing. Він створений для вивчення комунікацій між людьми в мережі: бот здатний навчатися під час спілкування з живими співрозмовниками, поступово стаючи більш персоналізованим.